半導體產業步入下行周期之際,2023年ChatGPT的“走紅”為產業帶來新的發展方向:AI人工智慧。 ChatGPT正掀起一場聲勢浩大的AI浪潮,AI時代下,為滿足海量數據存儲以及日益增長的繁重計算要求,半導體存儲器領域也迎來新的變革,HBM技術從幕後走向台前,未來前景可期。

突破“內存牆”瓶頸,HBM應運而生

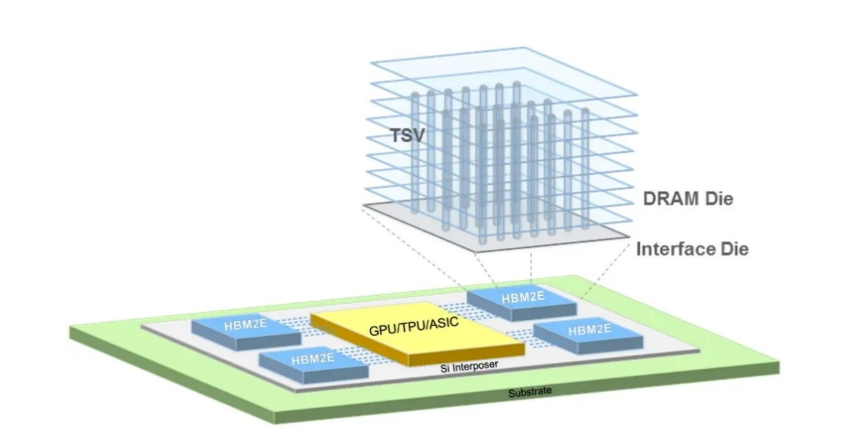

HBM(High Bandwidth Memory)即高帶寬存儲器,按照JEDEC的分類,HBM屬於圖形DDR內存的一種,其通過使用先進的封裝方法(如TSV矽通孔技術)垂直堆疊多個DRAM,並與GPU封裝在一起。

HBM通過矽通孔技術實現垂直堆疊

存儲器與處理器性能差異正隨時間發展逐漸擴大,當存儲器訪問速度跟不上處理器數據處理速度時,存儲與運算之間便築起了一道“內存牆”。 而隨著人工智慧、高性能計算等應用市場興起,數據爆炸式增長之下,“內存牆”問題也愈發突出。 為此,業界希望通過增加存儲器帶寬解決大數據時代下的“內存牆”問題,HBM便應運而生。

存儲器帶寬是指單位時間內可以傳輸的數據量,要想增加帶寬,最簡單的方法是增加數據傳輸線路的數量。 據悉,典型的DRAM晶片中,每個晶片有八個DQ數據輸入/輸出引腳,組成DIMM模組單元之後,共有64個DQ引腳。 而HBM通過系統級封裝(SIP)和矽通孔(TSV)技術,擁有多達1024個數據引腳,可顯著提升數據傳輸速度。 HBM技術之下,DRAM晶片從2D轉變為3D,可以在很小的物理空間裡實現高容量、高帶寬、低延時與低功耗,因而HBM被業界視為新一代內存解決方案。

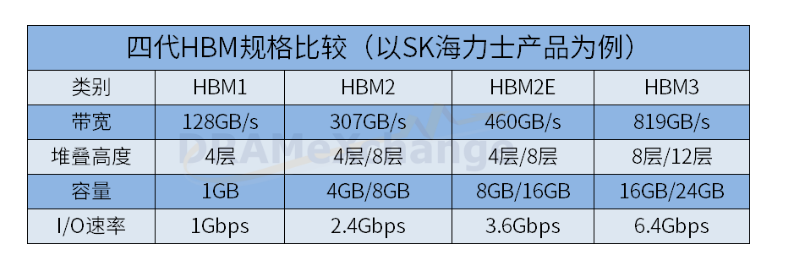

圖表:全球半導體觀察整理

自2014年首款矽通孔HBM產品問世至今,HBM技術已經發展至第四代,分別是:HBM(第一代)、HBM2(第二代)、HBM2E(第三代)、HBM3(第四代),HBM晶片容量從1GB升級至24GB,帶寬從128GB/s提升至819GB/s,數據傳輸速率也從1Gbps提高至6.4Gbps。

ChatGPT效應下,HBM需求持續看漲

與傳統DRAM相比,HBM具備高帶寬、高容量、低延時與低功耗等優勢,可以加快AI數據處理速度,更適用於ChatGPT等高性能計算場景。 當前ChatGPT等AIGC(生成式人工智慧)模型需要使用AI服務器進行訓練與推理,其中訓練側AI服務器基本需要採用中高端GPU,如Nvidia A100/H100等,在這些GPU中,HBM的滲透率接近100%; 而推理側AI服務器儘管目前採用中低端GPU,HBM滲透率不高,不過隨著AIGC模型逐漸複雜化,未來推理側AI服務器採用中高端GPU將是發展趨勢,未來這一領域的HBM滲透率也將快速提升。

ChatGPT風靡之下,AI效應正持續發酵,並不斷滲透雲端/電商服務、智能製造、金融保險、智慧醫療及 智能駕駛輔助等各行各業,AI服務器與高端GPU需求不斷上漲,並有望持續推動HBM市場成長。 全球市場研究機構TrendForce集邦諮詢預估2023年AI服務器(包含搭載GPU、FPGA、ASIC等)出貨量近120萬台,年增38.4%,占整體服務器出貨量近9%。 其中,NVIDIA GPU為AI服務器市場搭載主流,市占率約60~70%。

從高端GPU搭載的HBM來看,NVIDIA高端GPU H100、A100主采HBM2e、HBM3。 以今年H100 GPU來說,搭載HBM3技術規格,其中傳輸速度也較HBM2e快,可提升整體AI服務器系統運算效能。 隨著高端GPU如NVIDIA的A100、H100; AMD的MI200、MI300,以及Google自研的TPU等需求皆逐步提升,集邦諮詢預估2023年HBM需求量將年增58%,2024年有望再成長約30%。

HBM市場格局:SK海力士、三星、美光三分天下

HBM是新一代內存解決方案,其市場被三大DRAM原廠牢牢占據。 集邦諮詢調查顯示,2022年三大原廠HBM市占率分別為SK海力士50%、三星約40%、美光約10%。

公開資料顯示,SK海力士是HBM市場的先行者,也是全面布局四代HBM的廠商。 2014年,SK海力士與AMD聯合開發第一代矽通孔HBM產品; 2018年SK海力士發布第二代HBM產品HBM2; 隨後2020年SK海力士發布第三代HBM——HBM2E,作為HBM2的擴展版本,性能與容量進一步提升; 2021年10月SK海力士成功開發出第四代產品HBM3,並於2022年6月開始量產,今年4月,該公司進一步宣布,已經全球率先研發出12層堆疊的HBM3內存,單顆容量可達24GB。

三星對HBM的布局從HBM2開始,目前,三星已經向客戶提供了HBM2和HBM2E產品。 2016年三星量產HBM2; 2020年三星推出了HBM2; 2021年2月,三星推出了HBM-PIM(存算一體),將內存半導體和AI處理器合二為一; 2022年三星表示HBM3已量產。 另據媒體報道,三星已於今年4月26日向韓國專利信息搜索服務提交“Snowbolt”商標申請,預估該商標將於今年下半年應用於DRAM HBM3P產品。

美光進軍HBM相對較晚,相關產品公開報道不多。 2020年美光表示將開始提供HBM2產品,用於高性能顯卡,服務器處理器產品。 另據業界透露,美光亦在發力最新HBM3產品。

集邦諮詢指出,2023下半年伴隨NVIDIA H100與AMD MI300的搭載,三大原廠也已規劃相對應規格HBM3的量產。 其中,在今年將有更多客戶導入HBM3的預期下,SK海力士作為目前唯一量產新世代HBM3產品的供應商,其整體HBM市占率可望藉此提升至53%,而三星、美光則預計陸續在今年底至明年初量產,HBM市占率分別為38%及9%。

結語

當然,對於新一代內存解決方案而言,HBM並非十全十美,現階段HBM成本高昂,這就意味著該項技術暫時只能在服務器等高端領域應用,此外由於和主晶片封裝在一起,出廠已經確定規格,難以進行容量擴展,因此在服務器等領域,會出現HBM+DDR搭配使用的方案。

不過總體而言,在ChatGPT、人工智慧訓練和推理以及高性能計算等助力下,市場需要更多極速內存,HBM未來很長的時間內都將大有用處。

---------------------------------------------------------------------------------------------------------------------------------------------------------------------

參考鏈接:https://zhuanlan.zhihu.com/p/636737158